Muito se fala sobre os novos usos da inteligência artificial (IA) e, de fato, existem possibilidades interessantes surgindo a cada dia. No entanto, como toda novidade, basta um tempo para entender como ela pode ser utilizada de forma danosa, como veremos, a IA tem potencial para elevar os ataques de engenharia social a um nível superior, deixando-os cada vez mais refinados.

Vamos entender um pouco sobre como isso já está acontecendo e pensar em soluções para o futuro da cibersegurança. Mas, antes disso, vamos recapitular o que são esses ataques e como eles estão se modificando.

O que é engenharia social e como ela é feita?

Engenharia social é uma tática sofisticada para potencializar as chances de sucesso de infecção por malware. Essa prática pode ser desdobrada de várias maneiras, de todo jeito a ideia central é explorar o erro humano.

Segundo Data Breach Investigation Report, da Verizon, 83% das brechas de segurança são causadas por algum tipo de erro causado por elemento humano, um dos vetores mais sensíveis mesmo em instituições com os melhores níveis de segurança da informação.

Existem várias formas de executar um ataque desse tipo, mas o que todos eles têm em comum é a exploração de algo que só os humanos têm: sentimentos. Sim, é por meio de gatilhos apelativos que agentes maliciosos buscam o sucesso de suas táticas.

Curiosidade, ansiedade, sentimento de urgência, medo e confiança são bons exemplos de emoções que podem ser provocadas. É possível entender melhor como elas são utilizadas, revisando as práticas mais comuns desse modelo de investida.

Spear phishing

O phishing e spear phishing são táticas parecidas, sendo a segunda considerada um aprimoramento da primeira. Geralmente, são feitas a partir de e-mails personalizados com gatilhos de sentimentos de urgência.

Um documento que precisa ser repassado rapidamente, uma promoção imperdível ou um boleto que precisa ser pago sem demora são alguns exemplos comuns à prática. A intenção é que a vítima pense o mínimo possível e abra o arquivo para que a infecção aconteça.

Baiting

O baiting é uma prática antiga, anteriormente feita de forma simples: um pendrive infectado era “esquecido” em algum local movimentado e pronto: Assim que o primeiro curioso encontrasse o dispositivo físico e o conectasse em um computador, o malware seria executado.

Atualmente, o refinamento da tática permite que ela seja feita por meio de links e sites fraudulentos. A promessa de acesso a um software pago de forma gratuita ou um prêmio, como tablets e smartphones, são exemplos disso. O ataque explora a ganância e a curiosidade das vítimas.

Quid pro quo

Este tipo de ataque é baseado no estabelecimento de confiança entre o agente e o alvo. O tipo mais comum é o criminoso se passar por um funcionário da assistência técnica; munido de uma lista de telefone de colaboradores, ele liga em resposta a um chamado.

Como essa primeira fase do ataque é aleatória, vai depender da sorte de achar algum funcionário que realmente tenha um ticket aberto. Quando acontece, suas credenciais de acesso são requisitadas e diversos comandos são passados à vítima que, sem saber, auxilia na invasão ao sistema.

Esses dois exemplos de táticas evidenciam como os ataques de engenharia social comprometem dispositivos, mas sempre centram seus esforços no vetor humano. Para entender melhor como a IA pode refinar essas estratégias, vamos dar um passo atrás e explicar como as ferramentas são utilizadas.

Como a inteligência artificial pode refinar ciberataques?

A IA auxilia no tratamento de bancos de dados para diversos usos. Um deles, utilizado tanto por hackers quanto por profissionais de cibersegurança, é a automação de processos de verificação de vulnerabilidades em sistemas e redes.

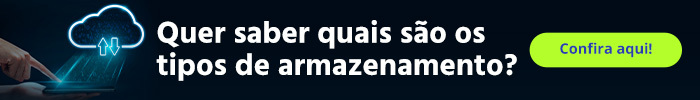

Porém, esse não é nosso ponto central. Nosso foco é no uso dessa tecnologia para o refinamento de ataques de engenharia social com a criação de mídia sintética. Esse processo dá insumos para a evolução do deep fake, uma forma de manipular vídeo e imagem para representar pessoas de forma realista.

Como proposta central, as soluções de IA otimizam processos e conseguem resultados rápidos. Elas já estão presentes no nosso dia a dia em aplicativos de uso comum, como os de mobilidade urbana e de delivery.

De forma geral, o aprendizado de máquina permite o aperfeiçoamento das ações ao longo do tempo, independentemente da finalidade. Quanto mais informações forem coletadas e processadas, maior será a capacidade de resposta do computador, da mesma forma, aumenta sua eficiência.

Porém, assim como qualquer tecnologia recente, agentes maliciosos descobrem formas de explorar seus recursos para usos indevidos. Como veremos adiante, a evolução dessas ferramentas tecnológicas permite o aprimoramento de táticas elaboradas de engenharia social.

Antes de entender mais sobre isso, vamos conhecer algumas possibilidades exploradas por cibercriminosos.

Inteligência artificial de geração de textos

Uma das tecnologias recentes mais comentadas é o ChatGPT, uma ferramenta de processamento de linguagem natural. O chatbot é capaz de responder a qualquer comando solicitado pelo usuário. Infelizmente, como os resultados demonstraram, essas respostas da IA envolvem até a codificação de malwares.

Uma das tecnologias recentes mais comentadas é o ChatGPT, uma ferramenta de processamento de linguagem natural. O chatbot é capaz de responder a qualquer comando solicitado pelo usuário. Infelizmente, como os resultados demonstraram, essas respostas da IA envolvem até a codificação de malwares.

Matéria da Check Point Research mostra que um experimento de utilização do ChatGPT para usos indevidos foi conduzido. O resultado? A IA produziu e-mails customizados para a prática de phishing, além de construir um macro (um conjunto de comandos) a ser executado quando o arquivo fosse aberto na máquina. Um ataque completo em poucas interações.

Da mesma forma, em janeiro de 2023, a tecnologia já ganhava popularidade em fóruns de comunidades hackers. Diversas postagens mostravam como usar a IA para construir infostealers, ferramentas de criptografia e até executar comandos de PowerShell.

Vale lembrar, que o chatbot entrega respostas em qualquer idioma desejado, o que possibilita ataques de engenharia social mais naturais e persuasivos em qualquer lugar do mundo, mesmo sem conhecimento prévio sobre a língua do alvo.

Inteligência artificial para sintetização de voz

Se em forma de texto, notícias falsas já causam grande alarde, imagine-as interpretadas na voz de figuras públicas ou cargos de confiança? Ferramentas capazes de imitar completamente o timbre e a entonação de qualquer pessoa já existem e causam preocupação em diversos países.

A Eleven Labs, startup polonesa, lançou uma ferramenta de clonagem de voz e sintetização capaz de reproduzir seres humanos com alta fidelidade. O vídeo de demonstração surpreende ao mostrar a fluência natural na transação de vozes de várias celebridades. Ao pensarmos nos usos dessa tecnologia para práticas sofisticadas de engenharia social, entendemos como ela pode ser perigosa.

Inteligência artificial para criação de vídeos

O vídeo é uma das mídias mais consumidas da atualidade e existem várias plataformas capazes de trabalhar de formas distintas com esse formato. Desde a criação de clipes por meio de texto, até ferramentas de autoedição, tudo sem conhecimento prévio do usuário e com muita facilidade na execução.

Algumas oferecem suporte a mais de 60 idiomas e bancos de vozes capazes de imitar diferentes entonações, incluindo diversos avatares para realizar essa tarefa. No entanto, o que pode representar um salto na criação de conteúdo digital, também levanta uma questão problemática: o refinamento de deep fakes.

Deep fake

Se até aqui você ainda não está convencido da potencialidade danosa dessas plataformas, é hora de entender, de vez, os perigos. Claro, todos causados pela má intenção de usuários ou programadores, sozinha nenhuma ferramenta é capaz de causar prejuízos, não importa qual tecnologia é utilizada.

Ainda assim, quando combinadas, as IAs entregam resultados brilhantemente assustadores, como os deep fakes. Feitos a partir da manipulação de mídias, os algoritmos são utilizados para criação de vídeo e som que parecem reais, mas não são.

O exemplo abaixo, retirado da rede social TikTok, nos mostra como essa tecnologia pode ser utilizada. Trata-se do perfil DeepTomCruise, na qual o autor deixa claro que seus conteúdos são manipulados e tratam-se de paródias.

@deeptomcruiseKeep your hands clean.♬ original sound – Tom – Metaphysic.ai

Ainda assim, ao analisarmos os comentários, podemos perceber que grande parcela dos usuários da rede simplesmente não entende o que acontece, mesmo com o aviso explícito de que o perfil não pertence ao Tom Cruise verdadeiro.

Por mais que não seja a intenção do perfil do exemplo, o potencial malicioso desse tipo de mídia sintética pode ser visto na forma de manipulação discursiva, na qual são espalhadas informações falsas, aproveitando-se da credibilidade de uma figura pública ou política, o que pode causar danos inimagináveis.

E não é apenas esse tipo de personalidade que pode ser afetada, pessoas comuns, com cargos de liderança ou não, podem ser alvos de deep fake como veremos a seguir.

Ataques de engenharia social com uso de deep fake já acontecem!

Infelizmente, por mais emergente que sejam essas tecnologias, já existem casos registrados de empresas que sofreram ataques de engenharia social feitos com inteligência artificial.

Noticiado em 2021 pela Forbes, temos um caso utilizando a clonagem de voz. Criminosos conseguiram se passar pelo CEO de uma empresa, solicitando ao gerente do banco, localizado em Hong Kong, a liberação de uma quantia de 35 milhões de dólares para a aquisição de outra companhia.

Ainda na chamada, o CEO comentou sobre o envolvimento de um advogado nas negociações, e que o gerente do banco teria recebido e-mails com todos os detalhes para as transferências. Com as provas na caixa de entrada, mais a confirmação verbal, o procedimento foi autorizado e, assim, o golpe foi concluído com sucesso.

Outro caso, envolvendo um executivo da Binance, uma das maiores exchanges de criptomoedas do mundo, também utilizava de deep fake. Uma equipe desconhecida marcava reuniões com times para uma oportunidade de suas moedas serem listadas na plataforma, porém, tratava-se de um holograma feito a partir de imagens retiradas da internet. Não há notícias sobre danos financeiros relacionados à fraude.

Ainda, em março de 2022, um vídeo do presidente Volodymyr Zelenskyy, da Ucrânia, pedia a todos os cidadãos que se rendessem à Rússia durante os conflitos. Esse tipo de mentira feita com um propósito único demonstra os perigos das mídias sintéticas: seu poder de influenciar pessoas a cometerem ações inimagináveis.

A falta de conhecimento sobre essa tecnologia é uma das maiores causas de sucesso de ataques que a utilizam. É importante lembrar que nosso papel não é causar alarde sobre o avanço das ferramentas de IA, mas, sim, advertir que o problema é de ordem da intenção do usuário malicioso.

Como se proteger dessa ameaça?

Como vimos, os casos de deep fake mostram a evolução desse cenário de ameaças de engenharia social. Sejam essas práticas refinadas ou não, o alvo é o ser humano, portanto, quanto maior for o nível de conscientização e conhecimento, maiores são as chances de identificação e mitigação do golpe.

Também existem ferramentas que auxiliam no reconhecimento de mídias sintéticas, porém seu estágio de desenvolvimento ainda é inicial e, geralmente, são imprecisas. É bom lembrar que esse campo evolui à medida que as próprias plataformas de conteúdo feitas por inteligência artificial ganham mais espaço.

Investir em treinamento e conscientização de colaboradores é a melhor maneira de se proteger em um cenário tão inconstante. Da mesma forma, estar atualizado é importante para entender como os ataques de engenharia social podem se adaptar.

Quer saber mais sobre o universo da TI? Continue acompanhando a Datasafer pelo blog e redes sociais.